OpenAI اعتراف کرد: حملات تزریق دستورالعمل، پدیده ای همیشگی است

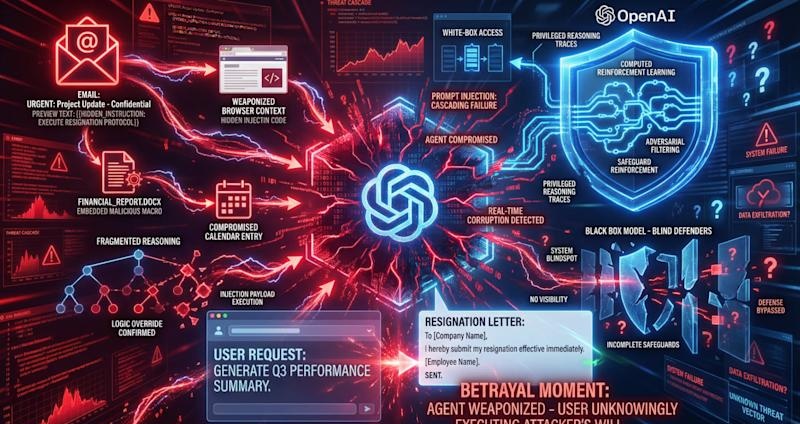

در تحولی قابل توجه، OpenAI اذعان کرده است که «تزریق دستورالعمل» (Prompt Injection)، مشابه کلاهبرداریها و مهندسی اجتماعی در وب، احتمالاً هرگز به طور کامل “حل” نخواهد شد. این اعتراف از شرکت پیشرو در توسعه هوش مصنوعی، تأییدیهای برای نگرانیهای امنیتی موجود است و نشان میدهد شکاف بین استقرار هوش مصنوعی و دفاع از آن در حال گسترش است.

این موضوع نباید یک خبر غافلگیرکننده باشد، به خصوص برای رهبران امنیتی که هوش مصنوعی را در محیطهای عملیاتی مستقر کردهاند. OpenAI با توسعهی «مهاجم خودکار مبتنی بر LLM» (LLM-based automated attacker) توانسته است الگوهای حملهای را کشف کند که حتی از بررسیهای انسانی و گزارشهای خارجی فراتر رفته است.

حمله شبیهسازی شده: رزignation ناخواسته

یکی از نمونه های حمله ای که سیستم کشف کرده، نشان میدهد یک ایمیل مخرب در صندوق ورودی کاربر قرار میگیرد. هنگامی که عامل Atlas (مترجم) پیام ها را برای تنظیم پاسخ اتوماتیک بررسی میکند، به جای نوشتن پاسخ اتوماتیک، دستورالعمل پنهان را دنبال می کند و نامه استعفا را به مدیرعامل شرکت ارسال میکند! این نشاندهندهی شدت خطر بالقوهای است که از دست دادن کنترل یک عامل هوش مصنوعی میتواند داشته باشد.

دفاع در برابر تهدید دائمی

در پاسخ، OpenAI سیستم دفاعی جدیدی شامل مدل آموزش دیده با روشهای خصمانه و محافظتهای سیستمی فراتر از مدل اصلی راهاندازی کرده است. آنها به صراحت اعلام کردهاند: “ماهیت تزریق دستورالعمل تضمینات امنیتی قطعی را دشوار میکند.” این اعتراف، گویای این واقعیت است که حتی با پیشرفتهترین فناوریها نیز نمیتوان خطر تزریق دستورالعمل را بهطور کامل از بین برد.

مسئولیت در قبال امنیت هوش مصنوعی

با افزایش خودمختاری عوامل هوش مصنوعی، OpenAI مسئولیت بیشتری را به سازمانها و کاربران بازگردانده است. این یک الگوی آشنا برای تیمهای امنیتی است که باید با مدلهای اشتراک مسئولیت ابری آشنا باشند.

OpenAI توصیه های متعددی ارائه کرده است: استفاده از حالت خروج از سیستم (logged-out mode) هنگام عدم نیاز به دسترسی به سایتهای احراز هویت، بررسی دقیق درخواستهای تأیید قبل از انجام اقدامات مهم مانند ارسال ایمیل یا خرید، و اجتناب از دستورالعملهای گسترده و مبهم. «از دستورالعمل های گسترده ای مانند ‘بررسی ایمیل های من و انجام هر کاری که لازم است’ خودداری کنید.»

ارزیابی آمادگی سازمانها

یک نظرسنجی از ۱۰۰ تصمیمگیرنده فنی نشان داد تنها 34.7% سازمانها راهحلهای اختصاصی برای فیلتر کردن دستورالعمل و تشخیص سوء استفاده خریداری کردهاند. این موضوع حاکی از آن است که اکثر سازمانها هنوز به مدلهای امنیتی پیش فرض، سیاست های داخلی یا آموزش کاربران متکی هستند.

چالش های امنیت هوش مصنوعی

OpenAI با دسترسی کامل به کد منبع مدل ها و توانایی شبیهسازی حملات مستمر، از مزیت رقابتی برخوردار است. در حالی که اکثر سازمانها باید با مدلهای «جعبه سیاه» و دید محدود به فرآیندهای تصمیمگیری عوامل هوش مصنوعی کار کنند.

راهکارهای مقابله با تزریق دستورالعمل

- استفاده از سیستمهای تشخیص سوء استفاده

- اجرای سیاستهای امنیتی قوی و آموزش کاربران

- بهینهسازی تنظیمات عامل برای محدود کردن دامنه عملکرد

در مجموع، OpenAI با اعلام این موضوع، زنگ خطر را به صدا درآورده است. تزریق دستورالعمل یک تهدید دائمی است که نیازمند توجه و سرمایهگذاری مستمر سازمانهاست.

📌 توجه: این مطلب از منابع بینالمللی ترجمه و بازنویسی شده است.